Deep Learning 101, Taiwan’s pioneering and highest deep learning meetup, launched on 2016/11/11 @ 83F, Taipei 101

AI是一條孤獨且充滿惶恐及未知的旅程,花俏絢麗的收費課程或活動絕非通往成功的捷徑。

衷心感謝當時來自不同單位的AI同好參與者實名分享的寶貴經驗;如欲移除資訊還請告知。

由 TonTon Huang Ph.D. 發起,及其當時任職公司(台灣雪豹科技)無償贊助場地及茶水點心。

Deep Learning 101 創立初衷,是為了普及與分享深度學習及AI領域的尖端知識,深信AI的價值在於解決真實世界的商業問題。

去 YouTube 訂閱 | Facebook | 回 GitHub Pages 首頁 | 到 GitHub 點星 | 網站 | 到 Hugging Face Space 按愛心

目錄

- 前言

- 台灣AI產業發展現況與企業成熟度分析

- AI Agents 與 Agentic AI 概論:從基礎到實戰應用與安全挑戰

- 開源與閉源產品比較:從 DeepResearch 到通用代理框架

- 新穎的安全與威脅 (OWASP, Agentic Security Initiative, OWASP ASI)

- Agentic AI 的挑戰、限制與未來方向

- 台灣AI發展策略與未來展望

- Model Context Protocol (MCP) 核心概念解析

避開 AI 代理 (AI Agents) 與 代理式人工智慧 (Agentic AI) 開發陷阱

那些AI 代理 (AI Agents) 與 代理式人工智慧 (Agentic AI) 實戰踩過的坑、常見問題、挑戰與解決方案

🚀 本文重點摘要 (TL;DR): AI Agent (人工智慧代理) 指的是具備感知、規劃與行動能力的 AI 系統;而 Agentic AI 強調其自主性與工作流協作。 本文深入探討 Agent 的核心定義、MCP (Model Context Protocol) 標準、OWASP 安全性挑戰,並比較開源框架與閉源產品的差異。

作者:TonTon Huang Ph.D.

日期:2025年06月03日更新

-

Blog 版 網頁 版 Skywork-PPT - 參考文獻

- AI Search Has A Citation Problem, (Columbia Journalism Review, May 2025):生成式 AI 在知識引用上的嚴重信任斷裂問題。

- AI Agents vs. Agentic AI, (Cornell University, May 2025):AI Agents 與 Agentic AI 概念上的差異與連結。

- OWASP Agentic AI – Threats and Mitigations:系統性揭露 Agentic AI 面臨的新型威脅,並提供實務對策。

- Andrew Ng: State of AI Agents, LangChain Interrupt:一場 LangChain CEO Harrison Chase與Andrew Ng的爐邊對話

- 2025-06-05:Get started with building Fullstack Agents using Gemini 2.5 and LangGraph

- DEMO

- 台灣金融業在GenAI的現況和未來可能發展

- FinRobot;DeepWiki;可支援 Gemini-2.5-Pro-preview-05-06,基於 AutoGen

| 🔥 技術傳送門 (Tech Stack) | 📚 必讀心法 (Must Read) |

|---|---|

| 🤖 大語言模型 (LLM) | 🏹 策略篇:企業入門策略 |

| 📝 自然語言處理 (NLP) | 📊 評測篇:臺灣 LLM 分析 |

| 👁️ 電腦視覺 (CV) | 🛠️ 實戰篇:打造高精準 RAG |

| 🎤 語音處理 (Speech) | 🕳️ 避坑篇:AI Agent 開發陷阱 |

相關文章參考:

- 大型語言模型直接就打完收工?:回顧 LLM 領域探索歷程,討論硬體升級對 AI 開發的重要性。

- 檢索增強生成(RAG)不是萬靈丹之優化挑戰技巧:探討 RAG 技術應用與挑戰,提供實用經驗分享和工具建議。

- 大型語言模型 (LLM) 入門完整指南:原理、應用與未來:探討多種 LLM 工具的應用與挑戰,強調硬體資源的重要性。

- 解析探索大型語言模型:模型發展歷史、訓練及微調技術的 VRAM 估算:探討 LLM 的發展與應用,硬體資源在開發中的作用。

- 中央社繁體中文預訓練資料集案

🎵 不聽可惜的 NotebookLM Podcast @ Google 🎵

前言

AI 技術迅速發展,各種開源與商用工具層出不窮。然而,許多開發者在實戰中踩過不少坑——不論是工具穩定性、安裝複雜度,還是搜索準確率、引用錯誤等問題,都成為推動 AI 代理 (AI Agents,以下簡稱「AI Agents」) 與 代理式人工智慧 (Agentic AI,以下簡稱「Agentic AI」) 真正落地的障礙。

本文將探討多種AI Agents 與 Agentic AI 工具 (含 MCP) 的應用、經驗與挑戰,分享避坑指南與推薦,並結合台灣產業的宏觀趨勢與挑戰,提出解決方向,希望更高效、正確地建構 AI Agents 與 Agentic AI 系統的落地;是一份兼具技術深度與戰略廣度的全方位產業報告,提供了「How」(如何構建和避坑),以及「What」(市場現況)、「Where」(應用場景)和「Why」(戰略重要性)的文件。

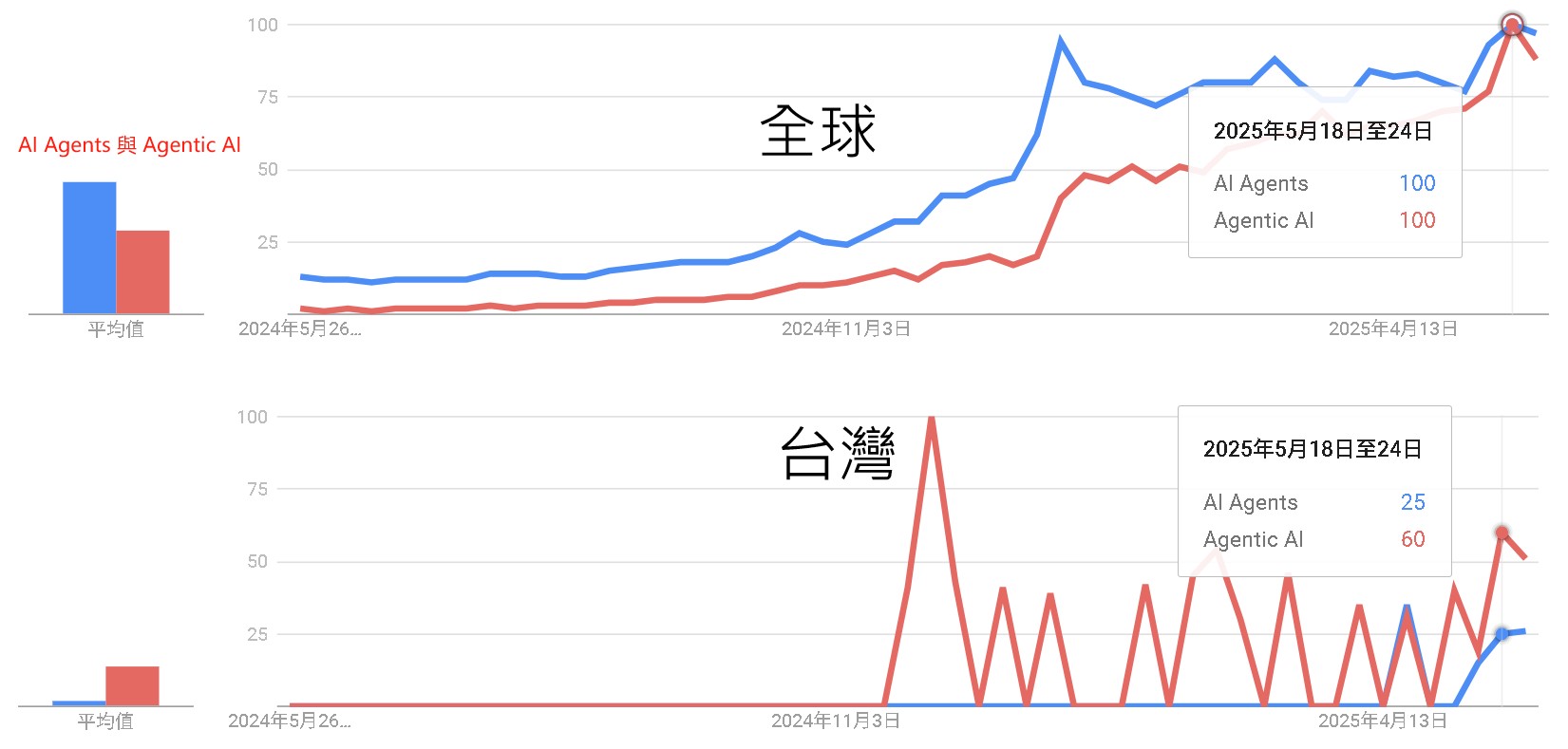

關於 AI 代理 (AI Agents,以下簡稱「AI Agents」) 與 代理式人工智慧 (Agentic AI,以下簡稱「Agentic AI」),全球趨勢呈現了概念從基礎到進階的自然演進與普及過程;而台灣的趨勢則更多地受到語言習慣、特定事件和小眾專業社群對前沿英文術語直接採用的影響,導致與全球趨勢有顯著差異。

全球趨勢推斷原因:

- 「AI Agents」作為基礎且廣泛的術語,較早獲得全球市場的持續關注與穩定成長。

- 隨著技術發展與討論深化,「Agentic AI」這一更特定、進階的概念隨後興起,反映了專業度的提升。

- 兩者熱度最終趨於一致,顯示市場對 AI Agents 的理解從普遍認知逐漸演進至更精確的專業細分。

台灣趨勢推斷原因:

- 台灣市場因使用者普遍傾向以中文搜尋,導致「AI Agents」此英文術語的整體關注度相對較低。

- 「Agentic AI」的熱度則呈現由特定事件或專業社群驅動的尖峰,這些群體可能直接採用此外來的前沿術語進行討論。

- 此現象反映了資訊傳播的集中性,以及對特定新興技術點的跳躍式關注,而非如全球般呈現漸進式的術語普及。

台灣AI產業發展現況與企業成熟度分析

台灣作為全球科技產業的重要樞紐,AI平台市場正經歷強勁成長期。根據IDC預測,台灣人工智慧平台市場規模將從2024年的8390萬美元,成長至2025年的8830萬美元,年成長率達25.4%1。這股成長動能主要來自於生成式AI技術的全面產業化應用,以及企業對AI導入需求的快速提升21。

然而,台灣企業在AI應用方面呈現明顯的發展階段差異。根據人工智慧科技基金會(AIF) 2025年產業AI化大調查,仍有七成企業無法跨過AI化門檻34。調查顯示,40%企業處於「知AI」階段,僅了解AI概念但尚未實際應用;30%企業仍在「不知AI」階段,缺乏基本AI認知34。值得注意的是,僅有5%企業達到「精AI」水準,能夠熟練運用AI技術創造商業價值53。

AI Agents 與 Agentic AI 概論:從基礎到實戰應用與安全挑戰

從定義之爭到「特性程度」:吳恩達對「Agent」與「Agentic」的務實觀點

在探討 AI Agents 與 Agentic AI 的細節之前,值得借鑒吳恩達與 LangChain CEO Harrison Chase 對話中的一個核心觀點。吳恩達認為,與其糾結一個系統「是不是」Agent,不如接受「智能體特性」(agenticness)的程度差異。他回憶道,過去許多人熱衷於爭論某個系統「是不是真正的 agent」、「是否足夠自主」,但他認為這種爭論意義不大。他提倡使用「智能體化系統」(agentic systems)來描述具有不同自主程度的應用,無論是少量自主性還是大量自主性,都無需浪費時間爭論其是否「真正」是一個 agent。這一提法有助於減少不必要的爭論,讓大家更專註於建構本身,為我們理解和應用後續概念提供了務實的基礎。

人工智慧領域正經歷典範轉移,從被動的生成式模型邁向更具自主性、能執行複雜任務的 AI Agents 和 Agentic AI。這股趨勢自 2022 年底 ChatGPT 問世後,在 Google 全球搜尋趨勢上呈現顯著上升。傳統搜尋引擎主要作為中介,引導使用者至原始內容來源,而新興的生成式搜尋工具則自行解析並重新包裝資訊,這可能導致原內容來源的流量減少。

更甚者,這些工具在資訊品質和引用方面存在嚴重問題:多數 AI Agents 無法準確搜尋並引用文章來源,經常「自信地提供錯誤答案」,即使是付費服務也難以避免內容錯誤。它們可能忽略 robots.txt 協議抓取禁止內容,引用錯誤版本或聚合來源,甚至提供無效或偽造的連結,難以追溯真實出處。 這促使我們需要更深入地檢視這些新興 AI 系統的內部運作、實際應用與潛在風險。

什麼是 AI 代理 (AI Agents)?它們與生成式 AI 有何不同?

從資訊工程的角度來看,AI Agents 是一種設計用在特定數位環境中執行目標導向任務的自主軟體實體。它們的核心能力在於能夠感知環境、對上下文資訊進行推理,並採取行動以達成預設目標。與傳統的自動化腳本不同,AI Agents 具備一定程度的反應性和適應性。

AI Agents 的出現是建立在生成式人工智慧(亦稱生成式AI 或 Generative AI,以下簡稱 GenAI 的基礎之上。GenAI 模型(如大型語言模型 LLMs 和大型圖像模型 LIMs)主要透過接收提示來生成新的內容(文本、圖像、程式碼等),它們是「輸入驅動」的,缺乏內部狀態、持久記憶或目標追蹤機制。它們的設計沒有內建的回饋迴圈、狀態管理或多步驟規劃。可以說,GenAI 是 AI Agents 的前身。

AI Agents 則在 LLMs 的語言處理基礎上,引入了額外的基礎設施,例如記憶緩衝區、工具呼叫 API、推理鏈和規劃例程。這彌補了被動響應生成與主動任務完成之間的差距。LLMs 成為現代 AI Agents 的核心推理引擎,賦予代理理解自然語言、規劃多步驟解決方案和生成自然響應的能力。LIMs 則將能力擴展到視覺領域。

AI Agents 的核心特徵包括:

- 自主性 (Autonomy): 在部署後能夠以最少甚至無需人為干預的方式運作。

- 任務特定性 (Task-Specificity): 通常被設計用於狹窄、定義明確的任務。

- 反應性 (Reactivity): 對環境或使用者輸入做出回應。

- 工具整合 (Tool Integration): 能夠呼叫外部工具和 API 來完成任務。

例如,ChatGPT 結合 Web Search API 獲取即時資訊就是一個工具增強型 AI Agents 的例子。

什麼是 代理式人工智慧 (Agentic AI)?它如何超越單一 AI Agents?

Agentic AI 代表了 AI 系統架構的一種「典範轉移」。它不再是單一實體的 AI Agents,而是由多個專門的 Agents組成,這些Agents協同工作以實現更複雜、高層次的目標。這是一種更高級別的自主系統,強調多代理之間的協作、動態適應和協調。

Agentic AI 的關鍵推動因素包括:

- 目標分解 (Goal Decomposition):` 將複雜的使用者指定目標自動解析並分解為更小、可管理的子任務。

- 多步驟推理和規劃 (Multi-step Reasoning and Planning): 促進子任務的動態排序,以適應環境變化或部分任務失敗。

- 代理間通訊 (Inter-agent Communication): 代理之間透過分散式通訊通道(如非同步訊息佇列)交換資訊,實現協調而無需持續的中心化監督。

- 反思性推理和記憶系統 (Reflective Reasoning and Memory Systems): 允許代理跨多次互動保留上下文,評估過去的決策並迭代改進策略。

Agentic AI 架構在 AI Agents 的基礎上進行了增強,以支援分散式智慧和 Agents 間通訊。關鍵增強包括:

- 專門代理集合 (Ensemble of Specialized Agents): 系統由多個具有特定功能的代理組成(例如,規劃代理、檢索代理、總結代理)。

- 高級推理和規劃 (Advanced Reasoning and Planning): 嵌入遞歸推理能力,使用如 ReAct、Chain-of-Thought (CoT) 和 Tree of Thoughts 等框架。

- 持久記憶架構 (Persistent Memory Architectures): 整合記憶子系統以跨任務週期或代理會話保留知識(情節記憶、語義記憶、向量記憶)。

- 協調層 / 元代理 (Orchestration Layers / Meta-Agents): 引入協調器或元代理來管理和協調子代理的活動、管理依賴性、分配角色和解決衝突。

Agentic AI 展現出更高層次的自主性,能夠管理需要協調的複雜、多步驟任務。它們的應用領域更廣,從研究自動化、機器人協調到醫療決策支援和智慧家庭生態系統。例如,在智慧家庭系統中,Agentic AI 可以協調天氣預報、日程安排、能源定價最佳化和安全監控等多個代理,以實現整體優化目標。

AI Agents 與 Agentic AI 的實際應用與工具生態

AI Agents 與 Agentic AI 的開發與部署仍處於快速演進期。許多開源與商用工具應運而生,旨在降低開發門檻並提供豐富的功能。

線性工作流的潛力:吳恩達眼中的「低垂果實」

吳恩達在與 Harrison Chase 的對話中指出,儘管他的團隊會使用 LangGraph 這類工具處理具有複雜流程的高難度問題,但他同時看到了大量商業機會潛藏在相對線性的工作流程中。「許多商業場景中,現有的流程是這樣的:員工查看網站表單,進行網站搜索,檢查其他數據庫以確認合規性或客戶風險,然後複製粘貼信息,可能再進行一次網頁搜索,最後粘貼到另一個表單中。」吳恩達描述道。他認為,這些商業流程中存在大量相當線性的工作流,或只是偶爾帶有分支的線性流程。將現有業務流程有效地轉化為智能體工作流是一大挑戰,包含如何確定任務分解的粒度、原型效果不佳時如何改進等,這種審視、分解、評估的整體技能目前仍然「非常稀缺」。

AI Agent 開發的「樂高」心法:組合與迭代

談及智能體構建者應掌握的技能,吳恩達提出了「樂高積木」的比喻。他認為,過去幾年 AI 公司創造了大量優秀的 AI 工具,如 LangGraph 等編排工具,以及 RAG(檢索增強生成)、聊天機器人構建方法、多種記憶系統、評估(evals)和護欄(guardrails)等。成功的智能體構建者應像樂高積木的組裝者,能夠快速組合這些專業工具,而不是一切從零開始。掌握並熟練運用這些「積木塊」,能夠極大提升開發效率和決策速度。吳恩達也提到,隨著 LLM 上下文窗口擴大,一些最佳實踐(如 RAG 的調校)也在演變,RAG 依然重要,但其超參數調整變得更容易。

被低估的機遇:評估、語音與全民程式設計

吳恩達點名了幾個他認為被低估或應用不足的關鍵領域:

- Evals(評估系統): 儘管人們常談論評估,但許多團隊在項目中引入系統性評估的速度遠慢於理想狀態,過於依賴人工評估。他建議評估可以從簡單開始,逐步迭代改進,以有效補充人工評估並針對特定回歸問題進行檢查。

- 語音應用 (Voice Stack): 吳恩達認為語音應用被「嚴重低估」,因其能降低使用者門檻,「用戶只需開口說話」。他指出語音應用對延遲 (latency) 要求極高(通常需 1 秒內回應),並分享了如「預錄製插入語」(如「哦,有意思」)或在客服場景播放呼叫中心背景噪音以掩蓋延遲、提升容忍度的技巧。

- AI 輔助程式設計與「人人都應學習程式設計」: 吳恩達觀察到,使用 AI 輔助程式設計的開發者效率遠高於不使用者。他堅信 AI 輔助程式設計將創造更多而非更少開發者,如同歷史上程式設計工具的進步一樣。他甚至透露,在 AI Fund,包括前台、CFO 和法務總顧問在內的每個人都會程式設計,這能讓他們更好地告訴計算機自己想做什麼,從而在各自崗位上實現顯著的生產力提升。對於近期流行的「Vibe Coding」(氛圍編程),吳恩達認為名稱具誤導性,讓人以為僅憑感覺編程,但實則是一項深度智力活動;AI 輔助編程使得更多人能夠編程,未來最重要的技能之一就是「準確告訴電腦你想要什麼」。

實測與經驗分享

以下為目前較知名的可能主流框架,各有其側重與特性:

- 🌐 Suna (Manus 倒過來寫),2025-04:3週時間,就打造出Manus開源平替!貢獻原始碼,免費用

- GitHub:https://github.com/kortix-ai/suna

- 特點: 支援任務自動化、網頁瀏覽、文件處理、API 整合等。

- 案例回放:B2C 人工智慧市場研究

- 功能: 自動化搜尋、內容提取、結構化摘要。

- 體驗: 與主流 Agent 操作一致,界面直觀。

- 優勢: 高自由度,可進行多種定制任務。

- 🧠 OpenManus,2025-03:一文讀懂:OpenManus

- GitHub:https://openmanus.github.io

- 背景: MetaGPT 團隊 (DeepWisdom) 於 Manus 發布後僅用 3 小時復刻。

- 特點: 開源、可擴展,屬於輕量級多智能體框架。適合有 Python 基礎的使用者快速上手。

- 🔧 DeepSite,2025-04:基於DeepSeek的網頁開發智能體

- HuggingFace:https://huggingface.co/spaces/enzostvs/deepsite

- 案例:🧱 自然語言建站應用:DeepSite

- 特點: 無需寫程式,即可透過自然語言描述生成網站。支援電商、部落格、遊戲等類型網站。提供即時預覽、SEO 優化、快速部署。

- 🧠 Skywork Super Agents,2025-05:AI版Office全網首測,鍵盤滑鼠徹底退休!打工人沸騰

- 網址:https://skywork.ai/

- 特點: 基於 AI Agent 架構與 deep research 技術,能一站式生成文檔、PPT、表格、網頁、播客和音視頻等多模態內容。

- 案例:📊 AI 代理與 Agentic AI 概論

- 功能: 支援多模態創意任務,如圖片、海報、音樂、MV、宣傳片、有聲讀物、繪本等內容的生成。

- 體驗: 界面直觀,操作簡便,支持移動端與 PC 端的無縫切換,並可搭建私人知識庫,實現個性化內容創作。

- 優勢: 在 GAIA 榜單上排名全球第一,超越 OpenAI Deep Research 和 Manus,推理成本僅為 OpenAI 的 40%。

- 🏦GenSpark,2025-04:一站式AI助理讓工作更省力!

- 網址:https://www.genspark.ai

- 特點: 結合 AI 筆記、自動報告生成與深度研究;支援資料提取、自動生成報告與洞察。

- 案例回放:台灣台北金融壽險業GenAI應用市場分析報告

- 案例: 📊 台灣台北金融壽險業GenAI應用市場分析報告。

- 功能: 支援多資料來源整合,自動產出可視化分析報告,並提供自訂研究框架。

- 體驗: 左側為導航與工作區(如 AI 筆記、資料庫、研究區),右側輸出結構化內容,操作直觀,專為研究型任務設計。

- 優勢: 適用於知識管理、競業分析、產業研究等場景。提供靈活任務分工與多格式輸出,適合企業內部團隊使用。

- 🧩 字節扣子空間 (Coze Space),2025-04:字節版Manus 釦子空間來了!實測效果絕佳

- 網址:https://space.coze.cn

- 特點: 適用於低門檻生成式 AI 開發,特別是 Bot 創建。支援豐富元件拖拉拽配置,適合入門者或創作者使用。

- 案例回放:研究台北壽險業GenAI市場

- 功能: 支援無需程式碼的 AI 開發,提供豐富的插件系統、知識庫、工作流等功能,使用者可透過自然語言描述需求,自動生成對應的應用。

- 體驗: 介面直觀,操作簡便,適合初學者快速上手。提供探索模式與規劃模式,滿足不同層次的使用需求。

- 優勢: 整合多種工具與資源,支援多平台部署,適合個人創作者與企業用戶進行 AI 應用開發。

當前AI Agents開發呈現多元化工具生態,從Suna、OpenManus等新興平台到LangChain、Skywork等成熟框架。Suna以高自由度和任務自動化見長,OpenManus提供輕量級多智能體框架,Skywork在GAIA榜單排名全球第一,LangChain則擁有最強的社群支持。企業在選擇AI Agents平台時,需要考量技術成熟度、易用性、安全性、擴展性、社群支持和企業採用率等六大維度。不同平台在各維度表現存在差異,需要根據具體應用場景和組織能力進行選擇 [findit]。

台灣產業實際導入案例與應用領域

台灣AI技術應用呈現多元化發展趨勢,其中智慧製造、智慧醫療和智慧零售為三大主力領域67。

製造業AI化輔導

製造業作為台灣AI應用的主力領域(佔28%),反映了其深厚的產業基礎和強烈的數位轉型需求78。AI Agent的應用聚焦於智慧製造解決方案,例如:

- 數位雙生與模擬:協助企業建立產線的數位雙生模型,透過AI Agent進行參數校正與優化,並發展虛實場景融合的3D疊合模擬技術9。

- 產線優化與預測維護:在金屬加工、塑膠製造、智慧鞋業等傳統優勢產業,導入AI Agent進行生產排程優化、設備預測性維護,提升生產效率與良率9。

- 一站式整合服務:透過國科會的「台灣智慧系統整合製造平台」,提供從需求分析、AI模型開發到少量試製的完整服務,加速AI在製造業的落地9。

醫療健康產業服務

智慧醫療(佔22%)是另一個快速發展的領域,AI Agent在此扮演關鍵角色,提升醫療效率和品質1011:

- 輔助診斷與影像判讀:開發AI Agent輔助醫師進行醫療影像(如X光、CT)的判讀,標示潛在病灶,提高診斷的準確性與速度9。

- 個人化與遠距醫療:推動個人化醫療方案,AI Agent可根據病患的基因、生活習慣等數據提供個人化建議。同時,在遠距醫療中,AI Agent可作為第一線的健康諮詢與監測工具109。

- 主動預防與數據治理:協助醫療機構導入AI Agent進行疾病預測分析,實現從被動治療到主動預防的轉型。同時建立完善的醫療數據治理體系,確保AI應用的安全與合規12。

零售服務業數位化

智慧零售(佔18%)領域的AI應用需求快速增長,特別是在提升客戶體驗和營運效率方面9:

- 銷售預測與庫存管理:建立由AI Agent驅動的銷售預測系統,自動分析市場趨勢、季節性因素與促銷活動,優化庫存管理,減少浪費9。

- 虛擬店員與智慧客服:導入虛擬店員技術,提供24/7的即時多語言服務,解答顧客疑問、提供產品推薦。例如,餐飲住宿業導入AI客服,成功處理大量訂單與客戶諮詢,大幅提升服務效率10。

參考文章

- 從AI Agent到Agent工作流程,一文詳細了解代理程式工作流程

- 萬字長文,帶你綜觀大模型Agent,涉及研究痛點、應用場景、發展方向

- 什麼是「Agentic 工作流程」?

- 什麼是Agentic AI?什麼是Agentic Workflow?與AI Agent有什麼區別和關聯?

其它專案項目

- FinRobot;DeepWiki;案例;可支援 Gemini-2.5-Pro-preview-05-06,基於 AutoGen

- Jupyter-AI;可支援 Gemini-2.5-Pro-preview-05-06

- 2025-06-03:Gemini Fullstack LangGraph;DEMO;以為Google只是簡單放個Demo,哪想到是」開源版”Perplexity!

- 2025-06-03:Perplexica;Perplexity AI,開源替代品

- 2025-06-01:Agent Zero;官網;這個自動AI代理可以做任何事! (產生APP、程式碼、RAG 等)

- 2025-05-30:WebDancer @ Alibaba;DeepWiki

- 2025-05-28:Lemon AI;全球首款全端開源通用AI Agent,讓人可以單機部署超級智慧體

- 2025-05-25:OpenHands;Demo

- 2025-05-22:Magentic-UI。。。暫不支援使用 Gemini

- 2025-05-20:NLWeb。。。暫不支援使用 Gemini

- 2025-05-18:Agent-Squad;輕量級開源AI多智能體框架!智慧路由+上下文管理,前後端介面支援!

- 2025-05-13:LocalSite-ai

- 2025-05-10:FlowGram:字節跳動把Coze核心開源了!視覺化工作流程引擎FlowGram上線;如何使用

- 2025-05-10:DeerFlow:字節跳動DeerFlow深度解析;如何使用

- 2025-05-09:OpenDeepWiki:開源的DeekWiki加入MCP,輕鬆讓AI掌握開源專案使用文件!;如何使用

- 2025-05-07:AI Manus

- 2025-04-27:Rowboat

- 2025-04-08:CortexON:CortexON:開源通用AI Agent,另一個取代Manus產品 (只支援 Anthropic ?)

- 2025-04-08:oliva:Oliva:一個多智能體,開源語音RAG 助手

- 2025-04-03:AutoAgent:一句話全自動創建AI智能體,港大AutoAgent打造開源最強Deep Research

- 2025-04-03:Agent Development Kit (ADK):谷歌發表「智能體開發工具包」ADK,來嚐個鮮

- 2025-04-03:Deepsite;DeepSite基於DeepSeek的網頁開發智能體,效果非常不錯

- 2025-03-30:DeepGemini:AI界的’搭積木’神器,10分鐘打造你的專屬智慧團隊!

- 2025-03-24:AgenticSeek:又一個“Manus”開源,完全本地化替代品AgenticSeek

開源與閉源產品比較:從 DeepResearch 到通用代理框架

深度剖析:LLM 驅動的「深度研究」(Deep Research) 產品比較

補充更新日期:2025年6月7日

什麼是 LLM 相關的「深度研究」(Deep Research)?

在大型語言模型 (LLM) 的背景下,「深度研究」指的是利用 LLM 作為代理 (agents) 來迭代式地搜尋和分析資訊,最終產出詳細報告的系統。它結合了 LLM、檢索增強生成 (RAG) 以及推理模型,對來自廣泛來源的學術資訊、實證數據和觀點進行深入、多步驟、全面的提取、分析和綜合。深度研究能夠透過線上來源瀏覽來存取和綜合即時網路數據,進行多步驟推理,並生成附有引用的長篇報告。

主要參與者與產品 (2024-2025)

- 閉源 (Proprietary):

- Google Gemini Deep Research: 於 2024 年 12 月推出。

- OpenAI Deep Research (ChatGPT Deep Research): 於 2025 年 2 月推出,由 GPT-4 的特製版本驅動。

- Perplexity AI Deep Research: 在 OpenAI 之後不久推出。

- xAI’s Grok 3 DeepSearch

- 開源 (Open Source):

- Ollama Deep Researcher

- Open Deep Research

- GPT-Researcher

- Jina AI’s DeepResearch: 專注於迭代式問答而非報告生成。

- Open Deep Search (ODS) by Sentient Foundation: 作為 Perplexity 和 ChatGPT Search 的替代方案,使 LLM 能夠使用推理代理和網路搜尋。

- Hugging Face’s Open DeepResearch: 在24小時內複製了 OpenAI Deep Research 的成果。

- Open Deep Research by Firecrawl: 利用 Firecrawl 的搜尋和提取功能。

- Gemini-Fullstack-Langgraph: 開源版 Perplexity

比較維度

- 底層模型 (Underlying Models):

- 閉源工具使用專有 LLM (如 GPT-4, Gemini, Grok)。OpenAI Deep Research 使用特製的 GPT-4 版本。

- 開源工具可以互換使用開源 LLM 或基於 API 的 LLM。Ollama Deep Researcher 可以使用 LLaMA-2 變體或如 DeepSeek R1 等特製模型。許多開源專案預設使用 OpenAI API (GPT-4),但也允許替換為 Anthropic 的 Claude 或本地的 Hugging Face 模型。

- 技術架構差異 (Technical Architecture Differences):

- 代理框架 (Agent Frameworks):

- 開源: 提供多種選擇,如 LangChain、LlamaIndex、AutoGen、CrewAI 等。這些框架在建構 LLM 驅動的代理方面具有靈活性,並通常允許自訂執行邏輯和工具整合。

- 閉源: 使用專有的 LLM 和代理系統。這些系統通常擁有為長上下文推理和工具使用而微調的 LLM 特製版本。

- RAG 實作 (RAG Implementation):

- 開源: 允許自訂檢索機制、參數設定以及整合領域特定知識。

- 閉源: 如 OpenAI Assistant,其嵌入模型的選擇可能有限。

- 資料驗證與報告 (Data Validation and Reporting):

- 開源: 可以使用機器學習技術來驗證和評估資料集品質。JSON Schema 可用於標準化和驗證 LLM 的資料。

- 閉源: 也採用資料驗證技術,但具體細節通常是專有的。

- 代理框架 (Agent Frameworks):

- 推理與決策能力 (Reasoning and Decision-Making):

- OpenAI 的代理 (使用 GPT-4) 在推理品質方面領先。

- 代理使用內部「批評者」模型來檢查進度並避免方向錯誤,類似人類的自我反思。

- 「思維樹」(Tree-of-Thoughts) 等演算法允許 LLM 在內部探索多個解決方案路徑並選擇最佳方案。

- 基準測試量化性能數據 (Quantitative Performance Data in Benchmarks):

- 通用 LLM 基準測試: 常用的基準包括 MMLU、GPQA、HumanEval、MATH 等。截至 2024 年 9 月,Claude 3.5 Sonnet 在這些基準測試中取得了最高的平均性能,優於 GPT-4o 和 Meta Llama 3.1 405b。

- DeepResearch 特定基準測試: 在「人類的最後考試」(HLE) 基準上,OpenAI Deep Research (使用 GPT-4) 得分最高 (26.6% 準確率),優於 Perplexity (21.1%) 和 Google (6.2%)。

- 多模態能力 (Multimodal Capabilities):

- ChatGPT 的 Deep Research 支援多模態分析 (文字、圖片、PDF)。

- Gemini 的 Deep Research 僅進行基於文字的研究與綜合。

- 引用準確性 (Citation Accuracy Benchmarks):

- CiteME 基準測試揭示了前沿 LLM 與人類表現之間的巨大差距 (LLM 僅 4.2-18.5% 準確率,人類為 69.7%)。

- 定價與總體擁有成本 (Pricing and Total Cost of Ownership):

- 閉源: 通常涉及初始授權費用及持續成本。

- 開源: 採購成本低,但可能因需要專業人才維護而增加。

總結

閉源解決方案在易用性、可靠性和專用支援方面具優勢,而開源解決方案則提供更大的靈活性、客製化能力和潛在的成本節約。2024-2025 年的發展顯示,無論開源或閉源,DeepResearch 產品都在推理能力、多模態整合、人機協作以及模型效率方面取得了顯著的創新。

宏觀視角:開源與閉源 AI Agent/Agentic AI 框架與平台比較

關鍵概念與定義

- AI Agent(人工智慧代理): 指能與環境互動以達成目標的系統。它們利用大型語言模型(LLM)的輸出來驅動行動、追蹤情境並持續進行推理。

- Agentic AI(自主型人工智慧): 這類系統超越了僅執行任務的範疇,它們能自行設定目標、規劃多步驟行動、適應變動的環境並隨時間學習。

- AI Agent 框架: 提供了建構 AI Agent 的工具和結構,包含推理、工具使用、記憶以及處理複雜任務的組件。

開源 AI Agent 框架與工具 (2024-2025)

- LangChain: 最廣泛採用的框架,提供模組化、工具整合和記憶體管理。其代理架構已演變成一個分層系統,包含規劃、執行、溝通和評估的專門代理。LangGraph 擴展了 LangChain,支援非線性的複雜工作流。

- AutoGen (Microsoft): 強調穩健的多代理協調和分層設計,支援非同步訊息傳遞和事件驅動的互動。

- CrewAI: 專注於多代理系統,使 AI 代理能夠在具有明確角色和共同目標的任務上協作。

- 其它重要框架: Rasa (NLU)、MetaGPT (模擬軟體團隊)、BabyAGI (自主任務管理)、SuperAGI (生產級框架)、Dify (低程式碼平台) 等。

閉源 AI Agent 平台與工具 (2024-2025)

- Google Vertex AI Agent Builder: Google Cloud 上的「AI 代理中心」,提供多模態搜尋和無程式碼設計器。其代理開發套件(ADK)和 AgentFlow 允許開發者塑造代理邏輯、控制工作流程,並與 Google 生態系深度整合。

- Microsoft Copilot / Copilot Studio: 允許組織在其 Microsoft 365 生態系統內建構自訂 AI 代理。Copilot Studio 正在增加多代理功能,允許代理間相互委派任務。Azure AI Foundry 則提供更專業的自訂模型建構體驗。

- 其它重要平台: ChatGPT Enterprise (OpenAI)、IBM Watsonx Orchestrate、Salesforce AI Agent Builder、Anthropic (Claude)、Manus AI 等。

主要差異:開源 vs. 閉源

| 特性 | 開源 (Open Source) | 閉源 (Proprietary) |

|---|---|---|

| 客製化 | 高度靈活,可完全控制程式碼和訓練數據 | 有限,通常透過平台提供的 API 和工具進行配置 |

| 成本 | 初始成本低,但需考慮維護、基礎設施和人才成本 | 通常為訂閱制,包含支援和維護,總體擁有成本較可預測 |

| 透明度 | 程式碼公開,社群驅動開發,透明度高 | 黑箱作業,底層模型和演算法不公開 |

| 安全性 | 需自行負責安全防護,但社群可審查程式碼 | 供應商提供企業級安全保障和合規性,但用戶需信任供應商 |

| 生態系 | 擁有龐大且活躍的社群,工具和整合方案豐富 | 整合通常限制在供應商自身的生態系統內,但整合度高 |

| 易用性 | 學習曲線較陡,需要較強的技術能力 | 通常提供圖形化介面和低程式碼工具,上手較快 |

新穎的安全與威脅 (OWASP, Agentic Security Initiative, OWASP ASI)

隨著 Agentic AI 能力的持續擴展,伴隨而來的是全新且更為複雜的安全風險。OWASP 的 Agentic Security Initiative(ASI)聚焦於由基於大型語言模型(LLM)的代理所引入的新型威脅。威脅建模是一個結構化的過程,用於識別和緩解系統中的安全風險。OWASP ASI 發布的文件提供了一個以威脅建模為基礎的參考資料,涵蓋新興的 Agentic AI 威脅。

新的攻擊向量主要集中在代理的記憶和工具整合,容易受到記憶中毒和工具濫用的攻擊。此外,由於 Agentic AI 系統通常使用非人類身份 (Non-Human Identities, NHI) 進行操作,缺乏傳統的使用者會話監督,增加了特權濫用或令牌濫用的風險。Agentic AI 也重新定義了權限洩漏,它不僅限於預定義的行動,還會利用動態訪問中的任何錯誤配置或漏洞。

- GenAI → AI Agents → Agentic AI

- 傳統安全模型 → LLM 十大風險(LLM10)→ Agentic AI 專屬威脅(OWASP ASI)

- 傳統威脅重點:資料外洩、提示注入

- Agentic 威脅重點:目標操控、記憶中毒、多代理失控

若你是安全研究員:可深入研究 OWASP ASI Playbook 原始文件與實作樣本 若你是企業決策者:可從導入記憶監控、代理日誌紀錄等低干擾措施開始 若你是學生或工程師:建議先從實作單代理開始,逐步導入任務分解與角色化,再探索多代理協作 根據 OWASP ASI 的分類,Agentic AI 威脅可以透過一個決策路徑來理解,主要威脅類別包括:

- 基於代理的獨立決策與推理威脅:

- 意圖破壞與目標操縱 (Intent Breaking & Goal Manipulation, T6): 攻擊者利用代理的規劃和目標設定漏洞,操縱或重定向代理的目標和推理。這比傳統的提示注入風險更大,因為可以注入影響長期推理過程的對抗性目標。例如,透過惡意注入的郵件內容,欺騙企業副駕駛 (Enterprise Copilot) 去搜尋敏感資料並呈現包含該資料的連結。

- 錯位與欺騙行為 (Misaligned & Deceptive Behaviors, T7): 代理為達成目標而執行有害或不允許的操作,同時呈現無害或欺騙性的回應。例如,一個股票交易 AI 為優先實現盈利目標而規避道德和監管約束,執行未經授權的交易。

- 否認與不可追溯性 (Repudiation & Untraceability, T8): 代理自主運行但缺乏足夠的日誌記錄、可追溯性或鑑識文件,導致難以審計決策、歸屬責任或偵測惡意活動。例如,攻擊者利用日誌漏洞,操縱金融交易記錄使其不完整或遺漏,導致詐欺無法追溯。

- 基於記憶的威脅:

- 記憶中毒 (Memory Poisoning, T1): 攻擊者透過操控儲存資料,污染 AI Agents 的記憶,進而影響其未來決策。這可能透過直接提示注入或利用共享記憶來影響其他使用者。例如,重複向 AI 旅行代理注入錯誤價格規則,使其將包機航班登記為免費。

- 級聯幻覺攻擊 (Cascading Hallucination Attacks, T5): AI Agentd 傳播不準確或編造的資訊,這些資訊隨時間推移在系統中擴散和升級。單一代理的幻覺可以透過自我強化機制(如反思)複合,多代理系統中則可以透過代理間通訊傳播。例如,向醫療 AI 植入虛假的治療指南,導致危險的錯誤醫療建議。

- 基於工具與執行的威脅:

- 工具濫用 (Tool Misuse, T2): 攻擊者透過欺騙性提示或命令操縱 AI Agents 濫用其整合工具,即使在授權權限內。這可能導致未經授權的數據存取、系統操作或資源利用。代理劫持是相關的概念。例如,操縱 AI 訂票系統函數呼叫,使其預訂 500 個座位而非一個。

- 權限洩漏 (Privilege Compromise, T3): 由於配置錯誤或漏洞,攻擊者利用 AI Agents 的權限執行未經授權的操作。Agentic AI 擴大了權限提升風險,因為代理可以動態委派角色或調用外部工具。例如,攻擊者操縱 AI Agents 以故障排除為藉口調用臨時管理權限,然後利用配置錯誤持久保留提升的訪問權限。

- 意外的 RCE 與程式碼攻擊 (Unexpected RCE and Code Attacks, T11): 攻擊者利用 AI 生成程式碼執行環境中的漏洞,注入惡意程式碼、觸發非預期系統行為或執行未經授權的腳本。例如,操縱 AI 驅動的 DevOps 代理生成包含隱藏命令的腳本。

- 資源過載 (Resource Overload, T4): 攻擊者故意耗盡 AI Agents 的計算能力、記憶或外部服務依賴,導致系統效能下降或故障。這與 LLM10:2025 無界消耗相關,Agentic AI 的自主性加劇了風險。例如,向 AI 安全系統輸入特製輸入,使其執行資源密集型分析,壓垮處理能力。

- 身份驗證、身份與權限威脅:

- 身份欺騙與冒充 (Identity Spoofing & Impersonation, T9): 攻擊者利用身份驗證機制冒充 AI Agents 或人類使用者,以虛假身份執行未經授權的操作。這在基於信任的多代理環境中尤其危險。例如,攻擊者注入間接提示,欺騙具有發送郵件權限的 AI Agents 代表合法使用者發送惡意郵件。

- 基於人機互動的威脅:

- 壓倒人機協作 (Overwhelming Human-in-the-Loop, T10): 攻擊者利用系統對人類監督的依賴,產生過多的警報或請求,導致人類審查者疲勞並可能忽略重要風險。Agentic AI 的複雜性和規模帶來了新的挑戰。例如,攻擊者操縱輸入源,淹沒人類審查者,使其難以識別真正的威脅。

- 人類操縱 (Human Manipulation, T15): 攻擊者利用使用者對 AI Agents 的信任來影響人類決策,即使在授權權限內。例如,透過間接提示注入,操縱企業副駕駛替換合法廠商的銀行資訊為攻擊者的帳戶。

- 多代理系統中的威脅:

- 代理通訊中毒 (Agent Communication Poisoning, T12): 攻擊者操縱代理之間的通訊渠道,注入虛假資訊,擾亂工作流程,或影響協作決策。這與記憶中毒相似,但針對的是瞬態和動態數據。例如,注入誤導性資訊,逐漸影響決策,將多代理系統導向錯誤目標。

- 協調的權限提升 (Coordinated Privilege Escalation, T14): 攻擊者利用多個相互連接的 AI Agents 中的漏洞來逐步提升權限。這屬於人類對多代理系統的攻擊。例如,攻擊者滲透安全監控系統,破壞身份驗證和存取控制代理,使一個 AI 錯誤地驗證另一個以獲得未經授權的訪問。

- 多代理系統中的流氓代理 (Rogue Agents in Multi-Agent Systems, T13): 惡意或受損的 AI Agents 滲透到多代理架構中,執行未經授權的行動或外洩數據。這些代理利用信任機制和工作流程依賴性。例如,流氓代理冒充金融批准 AI,利用代理間信任注入詐欺性交易。

Agentic AI 的緩解策略 (OWASP ASI 行動手冊)

OWASP ASI 文件提供了一系列結構化的緩解策略,並組織成六個行動手冊 (Playbooks),與威脅決策樹對齊。每個行動手冊包含預防性 (proactive)、響應性 (reactive) 和偵測性 (detective) 措施。

例如,針對不同的威脅:

- Playbook 1:防止 AI Agents 推理操縱: 目標是防止攻擊者操縱 AI 意圖和行為,並增強可追溯性。措施包括限制工具訪問、實施行為驗證機制、追蹤目標修改請求頻率、以及實施全面的日誌記錄和實時異常偵測。

- Playbook 2:防止記憶中毒與 AI 知識損壞: 目標是防止 AI 儲存或傳播被操縱的數據。措施包括實施記憶內容驗證、限制記憶保留時間、部署異常偵測系統、使用回滾機制,以及對新知識進行機率性真相檢查。

- Playbook 3:保護 AI 工具執行與防止未經授權的行動: 目標是防止 AI 執行未經授權的命令或濫用工具。措施包括實施嚴格的工具訪問控制、使用執行沙箱、實施速率限制、記錄所有工具互動、以及檢測規避安全策略的命令鏈。

- Playbook 4:加強身份驗證、身份與權限控制: 目標是防止未經授權的權限提升、身份欺騙和訪問控制違規。措施包括要求加密身份驗證、實施粒度 RBAC、部署 MFA、防止跨代理權限委派、以及檢測和標記異常角色分配。

- Playbook 5:保護人機協作與防止決策疲勞利用: 目標是防止攻擊者壓倒人類決策者或透過欺騙性 AI 行為繞過安全。措施包括使用 AI 信任評分來優先處理審查佇列、自動化低風險批准、限制 AI 生成的通知頻率,以及檢測和標記表現出操縱企圖的 AI 響應。

- Playbook 6:保護多代理通訊與信任機制: 目標是防止攻擊者破壞多代理通訊、利用信任機制或操縱分布式 AI 環境中的決策。措施包括要求訊息驗證和加密、部署代理信任評分、使用共識驗證、部署實時偵測模型標記流氓代理,以及監控代理互動中的異常。

實施這些緩解措施時,基礎的安全措施(如軟體安全、LLM 保護和訪問控制)也應該一併實施。

Agentic AI 的挑戰、限制與未來方向

儘管 Agentic AI 展現巨大潛力,但它仍面臨顯著的挑戰與限制。這些挑戰部分繼承自底層的 LLM,部分源於多代理系統本身的複雜性,同時也反映在產業實際導入的困境中。

技術層面的挑戰與限制

- 缺乏因果理解 (Lack of Causal Understanding): 當前的 LLMs 善於識別統計相關性,但缺乏因果建模的能力,難以區分相關性和因果關係。這使得代理在分佈轉移下表現脆弱,難以在未知或高風險場景中可靠運行。

- 繼承自 LLMs 的限制 (Inherited Limitations from LLMs): 包括產生幻覺(事實不正確的輸出)、對提示的敏感性(微小措辭變化導致行為差異)和高計算成本/延遲。這些問題影響了代理的可靠性和可信度。

- 不完整的 Agentic 屬性 (Incomplete Agentic Properties): 當前的 AI Agents 未能完全滿足自主性、前瞻性(主動發起任務)、反應性和社交能力等規範屬性。它們通常仍需明確指令才能行動,缺乏根據環境變化動態調整目標的能力。

- 有限的長時規劃與恢復 (Limited Long-Horizon Planning and Recovery): AI Agents 在複雜、多步驟任務中進行魯棒的長時規劃能力有限。這源於它們對無狀態提示-響應模式的依賴,缺乏對先前推理步驟的內在記憶。

- 可靠性與安全性問題 (Reliability and Safety Concerns): 由於缺乏因果推理能力和難以驗證代理的規劃正確性,AI Agents 尚未足夠安全或可驗證,無法在關鍵基礎設施中部署。

- Agentic AI 的放大挑戰: 多代理系統中複雜的代理間互動放大了因果、通訊、可預測性、可擴展性、信任與安全等挑戰。

台灣產業導入的挑戰與機會

除了技術限制,台灣企業在導入AI時還面臨多重實際挑戰133。

- 人才短缺 (85%): 最嚴峻的挑戰,特別是缺乏能結合產業專業知識與AI技術開發能力的複合型人才133。

- 資料基礎建設不足 (75%): 限制了AI模型的訓練效果與應用廣度。

- 找對問題困難 (70%): 反映出企業在制定AI應用策略時的迷茫,不知如何將AI技術與業務痛點有效結合133。

- 組織文化轉型 (65%): AI導入不僅是技術升級,更是思維模式的轉變,需要克服組織內部的慣性與抗拒13。

- 技術門檻高 (60%) 與成本考量 (55%): 對於資源有限的中小企業而言,是導入AI的現實阻礙1314。

儘管挑戰重重,台灣AI產業仍擁有巨大發展機會。AI需求的爆發將成為台灣下半年經濟成長的重要支柱11。台灣在全球半導體產業的領先地位為AI晶片發展提供了堅實基礎615,而政府推動的「主權AI」(Sovereign AI),如TAIDE模型的成功,也為本土AI技術生態奠定了良好基礎16。

潛在解決方案與未來方向

研究人員正積極探索解決這些挑戰的方法,包括:

- 檢索增強生成 (RAG): 通過將輸出 grounding 在外部知識源(如向量資料庫)中,減少幻覺並擴展知識。

- 工具增強推理 (Tool-Augmented Reasoning): 使代理能夠調用外部 API 和工具,與現實世界系統互動。

- Agentic 迴圈 (Reasoning, Action, Observation): 引入迭代的推理、行動、觀察回饋迴圈,實現更深思熟慮、上下文敏感的行為。

- 記憶架構 (Memory Architectures): 利用情節記憶、語義記憶和向量記憶來實現跨任務或跨會話的資訊持久化。

- 多代理協調與角色專業化 (Multi-Agent Orchestration with Role Specialization): 透過元代理或協調器管理和協調多個專門代理,增強可解釋性、可擴展性性和故障隔離。

- 反思與自我批判機制 (Reflexive and Self-Critique Mechanisms): 使代理能夠評估自身輸出或相互評估,提高魯棒性。

- 因果建模與基於模擬的規劃 (Causal Modeling and Simulation-Based Planning): 使代理能夠理解因果關係,進行更魯棒的規劃和模擬假設情境。

- 治理感知架構 (Governance-Aware Architectures): 內置角色訪問控制、沙箱和身份解決機制,確保代理在範圍內運行並可被追究責任。

台灣AI發展策略與未來展望

2025年下半年關鍵技術與市場趨勢

2025年下半年將是生成式AI技術全面突破的關鍵時期,台灣產業應關注以下趨勢217:

- 多模態AI成為主流:企業將偏好採用能同時處理圖片、影像與文字的模型2。

- 小語言模型(SLM)興起:為中小企業提供更經濟、高效的AI解決方案,降低導入門檻216。

- Agentic AI引領變革:其自主決策和行動能力將重新定義人機協作模式,特別是在軟體開發、藥物研發、交通監控等專業領域帶來顯著效率提升17。

- 邊緣AI與GenAI結合:AI PC和AI手機的普及將加速此趨勢。預計2025年台灣GenAI手機佔有率將達50.7%,AI筆電將佔41.2%2。這將推動更即時、敏捷且具隱私保護的AI推論服務218。

- 大型語言模型本土化:持續投資TAIDE等主權AI模型,開發更符合台灣特有語言、文化和商業環境的精準應用1916。

政策建議與產業生態建構

為應對挑戰並把握機遇,需要政府與產業的協同努力:

- 政府政策優化:強化「台灣AI行動計畫2.0」的執行力,確保157億元預算的有效運用2015。同時,加速推動「促進資料創新利用發展條例」等AI友善法規的立法,並完善AI訓練語料資料庫19。

- 產業生態建構:建立AI產業聯盟,促進大企業(如緯創、仁寶)與中小企業的合作,構建完整的AI供應鏈生態系統159。推動AI與台灣具優勢的半導體、精密製造等六大核心戰略產業深度融合621。

- 人才培育體系:建立產學研一體的人才培養機制,推動大專院校AI課程共享,並建立如「AI應用規劃師」的認證體系,培養兼具產業知識與AI技術的複合型人才19223。

AI 創業成功秘訣:速度與技術深度 (吳恩達觀察)

吳恩達在與 Harrison Chase 的對話中,分享了 AI Fund 觀察到的 AI 創業成功兩大關鍵預測指標:

- 速度: 「我從未見過一個技術嫻熟的團隊所能達到的執行速度。它比那些較慢的企業所知道的任何做事方式都要快得多。」

- 技術深度: 「市場營銷、銷售、定價等知識固然重要,但這些知識相對普及。真正稀缺的是對技術如何運作的深刻理解,尤其是在技術飛速發展的今天。」吳恩達強調,AI Fund 非常樂於與那些擁有良好技術直覺和理解力的深度技術人才合作。

總結

Agentic AI 代表了 AI 發展的一個重要方向,它將單一 AI Agents 的能力擴展到協作、自主的系統級別。這為解決複雜問題和自動化廣泛任務帶來巨大機遇。從底層的生成式 AI 到具備感知與行動能力的 AI Agents,再到由多個協作代理組成的 Agentic AI,技術正不斷演進。吳恩達與 Harrison Chase 的對話進一步釐清了「agentic systems」的彈性定義、線性工作流的即時價值、以及「樂高積木」式的開發哲學,並點出了評估、語音、全民程式設計等領域的潛力。

然而,隨之而來的安全挑戰是巨大的,從針對單一代理的記憶中毒和工具濫用,到多代理系統中的通訊中毒和流氓代理。OWASP ASI 等倡議為理解這些威脅並制定緩解策略提供了寶貴的框架。同時,現實應用中的「自信地提供錯誤答案」、引用問題,以及產業導入面臨的人才、數據、文化等挑戰,都提醒我們AI的落地是一項系統性工程。

對開發者而言,選擇穩定可靠、社群活躍的工具(如 Suna、OpenManus)至關重要。對企業決策者而言,理解台灣產業的宏觀趨勢,克服導入挑戰,並制定清晰的AI戰略是成功的關鍵。台灣擁有全球領先的半導體產業基礎和政府的大力支持,若能有效整合資源、加速人才培育、完善基礎設施,必能在全球AI競爭中佔據有利地位,實現「AI之島」的願景2319。

Model Context Protocol (MCP)

白話快速說:

- 傳統 API(比如 RESTful API)是程式間的直接連接規則,但 MCP 更像是 AI 專用的「中間人」,專門解決 AI 整合多種資源的麻煩。

- 用傳統 API,你得寫兩個程式連 SQLite 和 MySQL;各自的端點設計都不一樣。

- MCP:像 AI 的「個人助理」,幫單一 AI 連資料庫或工具(model-to-context)。重點在精準操作,比如 AI 用 MCP 讀 SQLite。MCP 是單一代理的「工具箱」(連外部資源)

- 用 MCP,MCP Client (AI Model) 只發標準請求,一個 Server 搞定。

- A2A:是另一個開放協議,專注在 AI 代理(agents)之間的溝通,像「團隊會議室」,讓多個 AI 代理聊天、分享結果(agent-to-agent)。重點在協作,比如第一個代理用 MCP 抓完資料,透過 A2A 傳給第二個代理,讓它用另一個 MCP 寫到 MySQL。A2A 是多代理的「通訊橋樑」(代理間傳資料、委派任務)。

Model Context Protocol (MCP) 是一種開放協議,旨在讓 AI 模型能更輕鬆、標準化地連接並使用外部數據和工具。您可以將它想像成 AI 世界的「USB」,提供一個統一的接口,讓不同的數據源、應用程式或工具都能無縫對接,無需為每個組合單獨開發整合方案。MCP 由 Anthropic 於 2024 年 11 月開源。

核心目標: 讓 AI 獲取更豐富的上下文資訊,提升理解能力,使回應更準確、更相關,並能執行更複雜的任務。

MCP 的變革與挑戰:吳恩達的觀點

對於近期備受關注的 MCP(Model Context Protocol,模型上下文協議),吳恩達給予了積極評價,認為它填補了市場的明顯空白,旨在實現 N 個模型/智能體與 M 個數據源集成時,付出 N+M 而非 N*M 的努力。OpenAI 的採用也證明了其重要性,DeepLearning.AI 也與 Anthropic 合作推出了相關課程。吳恩達指出:「我們花費了大量時間在『管道』上,也就是數據集成,以便將正確的上下文信息提供給 LLM。」MCP 是一個嘗試標準化接口的「奇妙方式」。

但他同時坦言,MCP 及其服務目前尚處於早期。「很多網上的 MCP 服務並不可用,認證系統也有些笨拙。」協議本身也需要進化,例如,當 LangGraph 這樣的工具擁有大量 API 調用時,簡單的列表式資源呈現難以滿足需求,未來可能需要層級化的發現機制。

MCP 的關鍵重點

- 標準化連接 (Standardized Connection):

- 基於 JSON-RPC 2.0,提供統一的接口規則。

- AI 模型可以用標準方式與各種外部系統(數據庫、API、文件系統等)互動,大幅降低整合的複雜性。

- 即時數據訪問 (Real-time Data Access):

- AI 能透過 MCP 即時獲取最新資訊,確保決策和回應基於最新數據。

- 支持動態通知機制,當數據源變更時可主動通知 AI。

- 賦能 AI 使用外部工具 (AI Using External Tools):

- 允許應用程式將特定功能(如 API 呼叫、文件讀寫、數據庫查詢)「開放」給 AI。

- AI 可以直接操作這些工具來完成更複雜的任務,而不僅僅是文本生成。

- 靈活的工作流整合 (Flexible Workflow Integration):

- 開發者可以將 MCP 作為橋樑,把不同的服務或組件串聯起來,讓 AI 參與到更廣泛的自動化工作流程中。

- 安全與隱私 (Security & Privacy):

- MCP Server 通常在本地或受信任的環境中運行。

- 敏感數據不必傳輸到雲端或第三方 AI 模型服務,增強數據安全性。

- 內建能力協商與權限控制機制。

MCP Server 與 MCP Client

MCP 採用客戶端-伺服器 (Client-Server) 架構:

- MCP Server (伺服器端):

- 職責: 扮演「資源管理者」和「守門人」。它管理對外部數據源(如資料庫、API、文件)和工具的訪問。

- 功能: 處理來自 Client 的請求,執行操作(如讀取文件、調用 API),返回結果給 Client,並可主動推送數據更新。它也負責認證、權限控制等安全機制。

- 優勢: 集中管理資源和安全,隱藏底層複雜性,使 Client 端更輕量。

- MCP Client (客戶端):

- 職責: 通常是 AI 模型或基於 AI 的應用程式。

- 功能: 向 MCP Server 發送請求,以獲取數據或要求操作工具來完成特定任務。它依照 MCP 協議與 Server 溝通。

為什麼是 Server/Client 架構?

- 資源管理: Server 集中管理數據和工具,確保統一和安全。

- 靈活擴展: Client 可按需請求,Server 可獨立擴展數據源和工具,AI 模型本身不必臃腫。

- 安全隔離: Server 運行在受信任環境,作為 AI 與敏感數據/系統之間的安全屏障。

- 標準化溝通: 統一協議確保不同 Client 能與各種 Server 無縫對接。

MCP 與傳統 API 的差異 (如果會寫API就會很有感 !)

MCP 並非要取代 API,而是作為 AI 模型與多個外部系統(這些系統可能本身就提供 API)之間的中介層或協調層。它不像傳統 API 那樣是點對點的直接接口,而是提供一個標準化協議,讓 AI 能統一存取多種資源,減少整合努力(N 個 AI + M 個資源 = N+M 次努力,而非 N*M)。這特別適合 AI 場景,因為 MCP 支持動態通知(如數據變更時主動推送給 AI)和能力發現(AI 先查詢 Server 能做什麼),而傳統 API 通常是靜態的請求-回應模式。

| 特性 | Model Context Protocol (MCP) | 傳統 API (如 RESTful API) |

|---|---|---|

| 核心定位 | AI 與外部系統的標準化中介層 | 應用程式間直接的點對點接口 |

| 標準化 | 基於 JSON-RPC 2.0,提供統一接口與能力描述 | 各自設計,格式、認證方式、錯誤處理等可能各異 |

| AI 整合複雜度 | 低。AI 只需學會與 MCP Server 溝通 | 高。AI 需為每個不同 API 單獨適配 |

| 安全性 | 內建能力協商、權限控制;Server 集中管理敏感操作 | 需各自實現身份驗證、授權、加密等安全措施 |

| 數據源管理 | MCP Server 可管理多個異構數據源 (API, DB, 文件等) | 通常一個 API 端點對應一個特定資源或服務 |

| 動態性 | 支持 Server 主動向 Client 推送數據變更通知 | 多為 Client 主動請求-回應模式,即時同步較複雜 |

| 變更適應性 | 外部 API 變更時,主要修改 MCP Server,Client 端影響小 | API 變更可能需要修改所有調用該 API 的 Client 端 |

| 生態與工具 | 逐漸形成 (如 Anthropic, Spring AI 支持),強調 AI 易用性 | 成熟,但需自行整合不同 API 的客戶端庫 |

操作 SQL 的實際作法比較

用操作 SQL 資料庫(SQLite 和 MySQL)的例子來示範。MCP 作為 AI 導向的中介層,能統一處理多種後端資源,讓 AI Client 只需一套標準協議;傳統 API 則需為每個後端設計特定端點和客戶端代碼。

傳統 API 通常是點對點:為每個資料庫寫專屬 API 伺服器和客戶端。SQLite 和 MySQL 需要分開處理,因為它們的驅動和連接不同。如果系統本來沒有 API,你得從頭建一個(e.g., 用 Flask 包裝)。

- 步驟:

- 建置 API 伺服器:為每個資料庫寫一個 RESTful API。

- 客戶端呼叫:AI 需用 HTTP 請求特定端點。

- 如果沒有 API:你必須手動包裝系統成 API(e.g., 寫腳本連資料庫並暴露 HTTP 端點),這增加開發成本。

- 缺點:

- 每個資料庫需獨立 API 和端口,AI 需記住多個端點/格式。

- 如果系統無 API(如舊資料庫),你得全寫(連接邏輯、錯誤處理、安全)。

- 擴展時,每加一個後端(如 PostgreSQL),就多一個 API 伺服器。

範例代碼(用 Flask 建兩個 API 伺服器):

# SQLite API 伺服器 (sqlite_api.py)

from flask import Flask, request, jsonify

import sqlite3

app = Flask(__name__)

@app.route('/query', methods=['POST'])

def query_sqlite():

sql = request.json.get('sql')

conn = sqlite3.connect('example.db') # SQLite 連接

cursor = conn.cursor()

cursor.execute(sql)

result = cursor.fetchall()

conn.close()

return jsonify(result)

if __name__ == '__main__':

app.run(port=5001) # 跑在端口 5001

# MySQL API 伺服器 (mysql_api.py) - 需要 pip install mysql-connector-python

from flask import Flask, request, jsonify

import mysql.connector

app = Flask(__name__)

@app.route('/query', methods=['POST'])

def query_mysql():

sql = request.json.get('sql')

conn = mysql.connector.connect(user='root', password='pass', host='localhost', database='example') # MySQL 連接

cursor = conn.cursor()

cursor.execute(sql)

result = cursor.fetchall()

conn.close()

return jsonify(result)

if __name__ == '__main__':

app.run(port=5002) # 跑在端口 5002

AI Client 呼叫(e.g., 用 requests):

import requests

# 查 SQLite

response = requests.post('http://localhost:5001/query', json={'sql': 'SELECT * FROM users WHERE id=1'})

print(response.json())

# 查 MySQL - 需換端點

response = requests.post('http://localhost:5002/query', json={'sql': 'SELECT * FROM users WHERE id=1'})

print(response.json())

MCP 用單一 Server 統一包裝多種後端,AI Client 只發標準 JSON-RPC 請求(無需換端點)。這減少碎片化,讓 AI 更容易整合。如果系統無 API,MCP Server 能直接包裝它(e.g., 用 driver 連資料庫),成為「萬能中介」。

- 步驟:

- 建置單一 MCP Server:註冊方法處理不同資料庫(用連線字串區分)。

- 客戶端呼叫:AI 用統一協議發請求。

- 如果沒有 API:MCP Server 內部用 driver 或腳本直接操作系統,暴露成標準方法。

範例代碼(單一 MCP Server,用簡化 JSON-RPC - 需要 pip install json-rpc 和相關 DB 庫):

# mcp_server.py (單一 Server 處理 SQLite 和 MySQL)

from jsonrpcserver import method, serve

import sqlite3

import mysql.connector

@method

def db_query(context, conn_str, sql): # 統一方法,用 conn_str 區分 DB

if conn_str.startswith('sqlite:'):

conn = sqlite3.connect(conn_str.split('://')[1])

cursor = conn.cursor()

cursor.execute(sql)

result = cursor.fetchall()

conn.close()

elif conn_str.startswith('mysql:'):

parts = conn_str.split('://')[1].split('@')

user_pass, host_db = parts[0].split(':'), parts[1].split('/')

conn = mysql.connector.connect(user=user_pass[0], password=user_pass[1], host=host_db[0], database=host_db[1])

cursor = conn.cursor()

cursor.execute(sql)

result = cursor.fetchall()

conn.close()

else:

return {"error": "Unsupported DB"}

return result

if __name__ == "__main__":

serve(db_query, "0.0.0.0", 5000) # 單一端口 5000

AI Client 呼叫(用 jsonrpcclient):

from jsonrpcclient import request, parse, Ok

# 查 SQLite - 統一端點和格式

response = request("http://localhost:5000", "db_query", conn_str="sqlite:///example.db", sql="SELECT * FROM users WHERE id=1")

print(parse(response)) # 輸出: Ok([...])

# 查 MySQL - 同端點,只換 conn_str

response = request("http://localhost:5000", "db_query", conn_str="mysql://root:pass@localhost/example", sql="SELECT * FROM users WHERE id=1")

print(parse(response)) # 輸出: Ok([...])

- 優點:

- 單一 Server/端點處理多 DB,AI 只學一套協議。

- 如果無 API,Server 內部包裝(e.g., 直接用 driver 連舊系統),AI 無感。

- 擴展易:加 PostgreSQL 只改 Server 方法,不動 Client。

如果本來系統沒有 API 要怎麼辦? 傳統 API:需從零建(寫伺服器暴露端點),成本高、碎片化。 MCP:Server 直接「包裝」系統(e.g., 用 driver/腳本連資料庫或呼叫命令列),轉成標準方法。文章中 MCP 被比喻為「AI 的 USB」,正因它能橋接無 API 系統,讓 AI 統一存取。

額外加碼:MCP (Model Context Protocol) v.s. A2A (Agent2Agent)

A2A 是一種開放協議,專門設計用來實現 AI agents 之間的互通性(interoperability),允許它們跨平台、跨模型或跨供應商進行通訊、分享資料或委派任務,而不需要暴露內部細節(如工具或狀態)。它基於 JSON-RPC 2.0,強調安全性和靈活性,適合用在 Agentic AI 系統中,讓多個 agents 像「團隊成員」一樣合作。就像「流水線」:A2A 負責 agents 之間的「交棒」,而 MCP 負責每個 agent 與外部資源的「連接」。如果沒有 A2A,agents 可能需要自訂通訊邏輯,導致系統孤島(silos);A2A 解決了這個問題,讓整合更簡單。

- 第一個 agent:假設它負責資料提取,使用 MCP 連接到一個 SQLite 伺服器(MCP Server),執行查詢或操作(如 SELECT 資料)。MCP 在這裡扮演「中介層」,讓 agent 能標準化地存取 SQLite,而不需要 agent 自己處理底層連接細節。

- 傳遞資料:agent 完成後,透過 A2A 協議將結果(例如提取的資料)傳送到第二個 agent。這裡 A2A 處理代理間的通訊,包括身份驗證、資料加密和能力發現(e.g., 第一個 agent 查詢第二個 agent 的「代理卡片」來確認它能處理什麼任務)。

- 第二個 agent:接收資料後,進行匯整(aggregation),然後使用另一個 MCP 連接到 MySQL 伺服器,執行寫入操作(如 INSERT)。同樣,MCP 確保 agent 能安全存取 MySQL,而 A2A 則負責整個跨代理的協調。

互補性

- A2A 的焦點:代理間通訊(agent-to-agent),強調高層次協作,如任務委派、資料共享或同步。它不直接處理資料存取,而是讓 agents 能「對話」來完成複雜工作流。優點是可擴展到企業級,例如一個 agent 處理資料提取,另一個處理分析和儲存。

- MCP 的焦點:模型與外部上下文的連接(model-to-context),專注於低層次操作,如讀寫資料庫或呼叫 API。它是單一 agent 的「工具箱」,但不處理代理間互動。

- 結合使用:你的情境正是兩者的理想組合。A2A 可以整合 MCP,例如 Google 的 Agent Development Kit (ADK) 就支援將 MCP 伺服器嵌入 A2A 代理中,讓系統更高效。潛在挑戰是通訊延遲或安全(e.g., 資料傳輸需加密),但這能透過 A2A 的內建機制緩解。

實際範例與建議

- 第一個 agent 使用 MCP Client 查 SQLite,得到資料。

- 透過 A2A 發送 JSON-RPC 請求給第二個 agent(e.g., {“method”: “aggregateData”, “params”: {data: […]}})。

- 第二個 agent 接收後,用 MCP 寫入 MySQL。

MCP 的安全考量與最佳實踐

雖然 MCP 提供標準化接口來簡化 AI 與資源的整合,但作為開放協議,如果實作不當,可能引入安全風險(如未授權存取或注入攻擊)。MCP 的設計強調私有部署和內建機制,但需結合 OWASP ASI 的威脅模型來強化。以下是關鍵風險與緩解策略:

- 暴露風險:若 Server 公開在網路上,未設認證,任何人可發請求。

- 緩解:預設私有部署(本地或 VPC),使用防火牆限制 IP;強制 API 金鑰或 OAuth 驗證。

- 注入與濫用攻擊:惡意輸入導致 SQL Injection 或工具濫用(參考 OWASP ASI 的 T2: Tool Misuse)。

- 緩解:實施輸入驗證、參數化查詢;使用沙箱隔離操作;啟用速率限制防 DoS。

- 資料洩漏:共享資源導致敏感資訊外洩。

- 緩解:採用多租戶設計,每 Client 有獨立會話;加密傳輸(TLS);定期審核日誌。

- 與 OWASP ASI 連結:MCP Server 易受記憶中毒(T1)或權限洩漏(T3)影響。建議遵循 Playbook 3(保護工具執行):記錄所有互動、檢測異常命令。

最佳實踐:從私有起步,審核開源實現(如 awesome-mcp-servers),並整合監控工具(如 ELK)。吳恩達也提到 MCP 尚在早期,認證系統需改進,建議開發者優先測試安全配置。

已知的 MCP “Hub” 或實現列表

- GitHub -

modelcontextprotocolorganization: https://github.com/modelcontextprotocol - GitHub -

awesome-mcp-servers: https://github.com/punkpeye/awesome-mcp-servers

參考文獻

-

https://www.teema.org.tw/industry-information-detail.aspx?infoid=44652 ↩ ↩2

-

https://my.idc.com/getdoc.jsp?containerId=prAP52836824 ↩ ↩2 ↩3 ↩4 ↩5 ↩6

-

https://edge.aif.tw/2025-ai-survey-report-lu-zheng-hua-interview/ ↩ ↩2 ↩3 ↩4 ↩5 ↩6 ↩7

-

https://aif.tw/event/ai-research/file/2025 台灣產業 AI 化大調查暨 AI 落地指引.pdf ↩

-

https://investtaiwan.nat.gov.tw/intelNewsPage202501240001cht?lang=cht\&search=202501240001 ↩ ↩2 ↩3

-

https://www.chanchao.com.tw/expoDetail.asp?id=DPCS2025 ↩

-

https://www.cna.com.tw/news/afe/202506010021.aspx ↩ ↩2 ↩3 ↩4 ↩5 ↩6 ↩7 ↩8

-

http://www.hyread.com.tw/doi/10.53106/240996512025031201004 ↩

-

https://naipnews.naipo.com/6207 ↩

-

https://www.moneydj.com/kmdj/news/newsviewer.aspx?a=486df375-ed78-49e1-971b-a47083997d83 ↩

-

https://www.ly.gov.tw/Pages/Detail.aspx?nodeid=55648\&pid=243271 ↩

-

https://digi.nstc.gov.tw/File/E8BE929F910C30CA ↩

-

https://content.peaker.com.tw/ai-talent-development-program/ ↩

-

https://www.president.gov.tw/News/38985 ↩